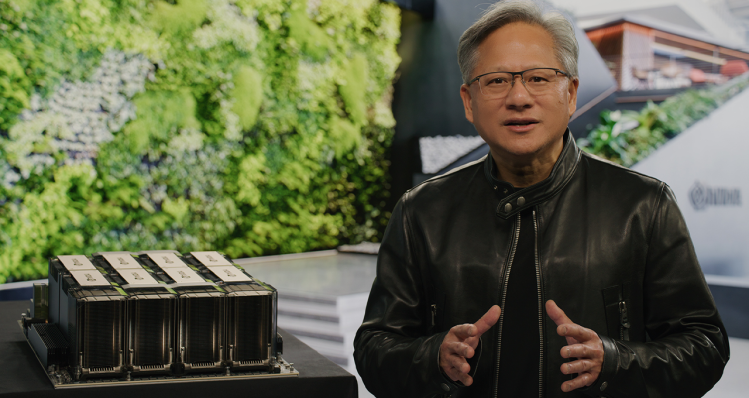

随着英伟达年度GTC会议的举行,创始人兼首席执行官黄仁勋(Jensen Huang)穿着他特有的皮夹克,站在加利福尼亚州圣克拉拉英伟达总部的垂直绿色墙前,发表了一场备受期待的主题演讲,几乎完全专注于人工智能。他的演讲宣布与谷歌、微软和甲骨文等公司建立合作伙伴关系,为“每个行业”带来新的人工智能、模拟和协作功能。

“曲速驱动引擎是加速计算,能源是AI,”黄说。他说,生成式人工智能功能“为公司重新构想其产品和商业模式创造了一种紧迫感。工业公司正在竞相数字化并重塑为软件驱动的科技公司,成为颠覆者而不是被颠覆者。

黄磊的主题演讲以标志性的“我是AI”开场(于2017年推出)拉开序幕,这一次的音乐显然是由人工智能创作的,由作曲家约翰·内萨诺(John Naesano)编曲。然后,黄炜开始发布一系列令人眼花缭乱的公告。其中包括从培训到部署尖端人工智能服务的所有内容;新的半导体和软件库;以及为初创企业和企业提供的一整套系统和服务。

GTC的公告针对英伟达超过四百万开发人员的社区,是在英伟达持续占据人工智能主导地位的背景下发布的,尤其是在最新的生成人工智能时代。

正如VentureBeat最近的深度专题报道所详述的那样,当Nvidia的硬件和软件公司帮助推动十年前的深度学习“革命”时,Nvidia获得了巨大的AI领先优势,并且随着生成AI与ChatGPT等工具的爆炸式增长,几乎没有失去领先地位的迹象。

事实上,Nvidia为ChatGPT提供支持:根据瑞银分析师Timothy Arcuri 的说法,ChatGPT使用了10,000个Nvidia GPU来训练模型。

黄说,英伟达的技术是人工智能的基础,他讲述了英伟达在生成人工智能革命之初是如何存在的。在他的主题演讲中,黄讲述了他在2016年如何亲手交付给OpenAI的第一台Nvidia DGX AI超级计算机 - 为ChatGPT提供动力的大型语言模型背后的引擎。

据Huang报道,Nvidia DGX超级计算机最初用作AI研究仪器,现在在世界各地的企业中24/7全天候运行,以完善数据和处理AI。财富 100 强公司中有一半安装了 DGX AI 超级计算机。“DGX超级计算机是现代人工智能工厂,”黄说。

英伟达称DGX为AI基础设施的蓝图

最新版本的DGX具有八个Nvidia H100 GPU,它们连接在一起,作为一个巨大的GPU。“Nvidia DGX H100是客户在全球范围内构建AI基础设施的蓝图,”黄说,并分享Nvidia DGX H100现已全面生产。

他补充说,H100 AI超级计算机已经上线。Oracle 云基础设施宣布推出采用 H100 GPU 的全新 OCI 计算裸机 GPU 实例,数量有限。亚马逊网络服务公司宣布推出EC2 UltraClusters的P5实例,其规模可扩展到20,000个互连的H100 GPU。这是继Microsoft Azure上周宣布其H100虚拟机ND H100 v5的私人预览版之后。

Meta 现在已经在内部为其 AI 生产和研究团队部署了其基于 H100 的“Grand Teton”AI 超级计算机。OpenAI将在其Azure超级计算机上使用H100来为其持续的AI研究提供动力。

英伟达 DGX 云将 AI 超级计算机“带到每家公司”

为了加快初创公司和企业构建新产品和开发人工智能战略的DGX功能,黄宣布了Nvidia DGX Cloud。通过与Microsoft Azure,Google Cloud和Oracle云基础架构的合作,Nvidia DGX Cloud将“通过浏览器将Nvidia DGX AI超级计算机”从浏览器带到每家公司”。

DGX Cloud 经过优化,可运行 Nvidia AI Enterprise,这是世界领先的加速软件套件,用于 AI 的端到端开发和部署。Nvidia 正在与领先的云服务提供商合作,从 Oracle 云基础设施开始托管 DGX 云基础设施。微软Azure预计将在下个季度开始托管DGX Cloud,该服务将很快扩展到Google Cloud。

黄说,这种合作关系将英伟达的生态系统带给了云服务提供商,同时扩大了英伟达的规模和覆盖范围。企业将能够按月租用DGX云集群。

面向企业的定制LLM和生成式AI

为了加速那些寻求利用生成式AI的人的工作,Huang宣布了Nvidia AI Foundations,这是一个云服务系列,适用于需要构建,完善和操作自定义LLM和使用其专有数据训练的生成AI以及特定领域任务的客户。

AI Foundations 服务包括用于构建自定义语言文本到文本生成模型的 Nvidia NeMo;Picasso,一种视觉语言模型制作服务,适用于希望构建使用许可或专有内容训练的自定义模型的客户;和BioNeMo,以帮助2万亿美元药物发现行业的研究人员。

Huang宣布与Adobe-Nvidia建立合作伙伴关系,以构建一套下一代AI功能。Getty Images 正在与 Nvidia 合作,训练负责任的生成文本到图像和文本到视频基础模型。Shutterstock正在与Nvidia合作,训练一个生成的文本到3D基础模型,以简化详细3D资产的创建。

英伟达发明了人工智能加速计算,包括深度学习

英伟达发明了加速计算来解决普通计算机无法解决的问题,黄说。“它需要从芯片、系统、网络、加速库到重构应用程序的全栈发明。

他解释说,每个优化的堆栈都加速了一个应用领域——从图形、成像和量子物理学到机器学习。“该应用程序可以在许多计算机上享受令人难以置信的加速和扩展。这使我们能够在过去十年中为许多应用程序实现一百万倍,“他说。

他指出,英伟达加速计算最著名的应用是深度学习。

2012年,Alex Krizhevsky,Ilya Sutskever和Geoffrey Hinton需要一台速度极快的计算机来训练AlexNet计算机视觉模型。Huang解释说,研究人员训练了AlexNet,在GeForce GTX 14处理和580千万亿次浮点运算上提供了262万张图像。经过训练的模型以很大的优势赢得了ImageNet挑战,黄说,“点燃了人工智能的大爆炸”。

十年后,Transformer模型被发明出来,现在在OpenAI工作的Sutskever训练了GPT-3大型语言模型来预测下一个单词。Huang说,训练GPT-323需要3个六分浮点运算,比训练AlexNet多一百万倍。

“结果是ChatGPT,全世界都能听到的人工智能,”他说。

Huang和Sutskever肯定会在定于明天太平洋时间上午9点举行的炉边谈话中讨论这一切,甚至更多。

椰有料原创,作者:小椰子啊,转载请注明出处:http://www.studioyz.com/2140.html

文章评论